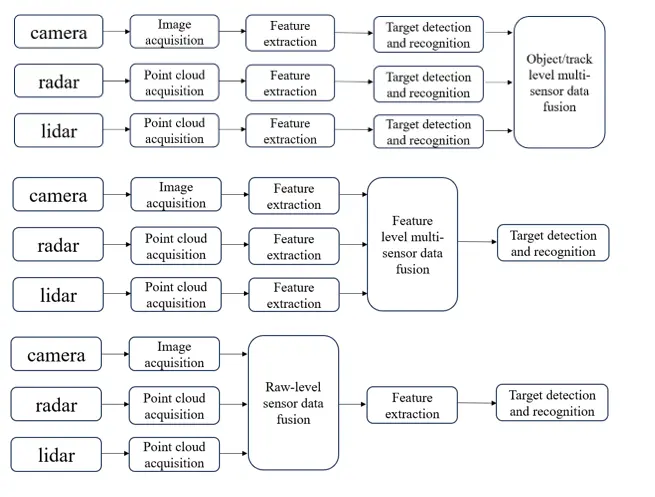

Um Wahrnehmungsalgorithmen für vernetzte Mobilität und Infrastruktur zu entwickeln, ist ein zuverlässiges, robustes und modifizierbares Software-Framework erforderlich. Daher wird in unserer Forschungsgruppe das Robot Operating System (ROS) eingesetzt. Es ist die Plattform der Wahl für die Forschung und Entwicklung von Multisensor-Software. Die primären Sprachen für unsere Softwareentwicklung sind Python und C++, wobei wir die neuesten Softwareentwicklungsstrategien einsetzen. Die Multisensordatenfusion umfasst verschiedene Softwarearchitekturen, von denen einige im Folgenden skizziert werden.

Vernetzte Mobilität und Infrastruktur

Sensoren

Kameras gehören zu den am weitesten verbreiteten Sensoren für vernetzte Mobilität und Infrastrukturwahrnehmung. Sie liefern hochauflösende Farbbilder, die umfangreiche und detaillierte Informationen über die Umgebung liefern. Im Vergleich zu anderen Sensoren sind sie kostengünstig, leicht und kompakt. Kameras arbeiten effektiv mit Computer-Vision-Algorithmen und künstlicher Intelligenz, um verschiedene Verkehrsteilnehmer zu erkennen und zu verfolgen. Sie sind in der Lage, Live-Ereignisse in Echtzeit zu überwachen, was für die vernetzte Mobilität und Infrastruktur entscheidend ist. Darüber hinaus ermöglicht der Einsatz mehrerer Kameras die Erfassung verschiedener Blickwinkel und Ansichten einer Umgebung, wodurch ein umfassenderes Verständnis der Umgebung entsteht. Wir setzen verschiedene Kameramodelle von Unternehmen wie IDS, Basler und Flir ein, um nur einige zu nennen. Diese sind mit verschiedenen Schnittstellen wie GigE und USB ausgestattet. Diese Kameras werden sowohl in Fahrzeugen als auch in Infrastruktureinrichtungen zur Verkehrsüberwachung, zur Erkennung von Verkehrsteilnehmern, zur Bewegungsvorhersage, zur Erkennung von Baustellen usw. eingesetzt. In einigen Projekten setzen wir auch Wärmebildkameras ein. Da RGB-Kameras personenbezogene Daten aufzeichnen können, verwenden wir verschiedene Algorithmen zur Datenanonymisierung, um sensible personenbezogene Daten aus den Kamerabildern zu entfernen und so die Datenschutzbestimmungen einzuhalten.

LiDAR (Light Detection and Ranging) Sensoren gelten im Bereich der Umfeldwahrnehmung als Schlüsselelement zum zukünftigen automatisierten Fahren. Dabei zählen diese Sensoren zu den optischen Sensoren, welche im Nahinfrarotbereich arbeiten und die Umgebung mittels eines kurzgepulsten Lasers abtasten. Durch Messung der Laserlaufzeit zum getroffenen Objekt kann die Objektdistanz mit bis zu einer Genauigkeit im mm-Bereich gemessen werden. So kann mithilfe der bekannten Abstrahlrichtung ein sehr genaues, fein aufgelöstes 3D-Modell der Umgebung in Form einer sogenannten Punktwolke (engl. Pointcloud) generiert werden. Auf Basis dieser können sowohl statische als auch dynamische Objekte wie Fußgänger und Fahrzeuge präzise erkannt und einer nachgeschalteten Fahrfunktion übermittelt werden.

Im Allgemeinen unterscheidet man scannende (Abbildung oben) und nicht scannende LiDARe (Abbildung unten). Erstere sind weitaus verbreiteter und Erfassen die Umgebung durch einen gerichteten Laserstrahl, welcher durch einen Scanning-Mechanismus umgelenkt wird und im Rasterverfahren ein Abbild dieser erzeugt. Letztere werden auch als Festkörper-LiDARe oder Flash LiDARe bezeichnet. Diese zeichnen sich dadurch aus, dass keine beweglichen Komponenten zur Abtastung der Umgebung benötigt werden, was sich als durchaus vorteilhaft für dessen Robustheit erweist. Anstelle eines Scans wird die gesamte Umgebung mithilfe eines einzelnen diffusen Laserpulses erfasst, welcher letztlich mithilfe einer entsprechenden Empfängeroptik auf einen Bildsensor projiziert wird, ähnlich einer Blitzlicht- (Flash) Kamera.

Radar-Sensoren spielen eine entscheidende Rolle in der vernetzten Mobilität und Infrastruktur, da sie eine Vielzahl von Vorteilen bieten. Im Vergleich zu anderen Sensoren zeichnen sie sich durch ihre Robustheit und ihre Fähigkeit aus, zuverlässige Daten unabhängig von Tageszeit und Wetterbedingungen zu liefern. Darüber hinaus sind sie anonymisiert, was bedeutet, dass sie keine personenbezogenen Daten erfassen und somit den Datenschutzbestimmungen entsprechen.

Radar-Sensoren ermöglichen die Identifikation und Klassifizierung von Zielen sowohl in kurzen als auch in größeren Entfernungen. Für unsere Sensordatenfusion und die Entwicklung radarbasierter Algorithmen setzen wir auf hochwertige Radarprodukte von Continental wie die ARS408, ARS430 und ARS548, sowie auf Lösungen von Oculii. Darüber hinaus nutzen wir Radar-Sensoren mit Rohdatenschnittstelle, um auf einer tieferen Entwicklungsstufe zu arbeiten, insbesondere bei der Nutzung des Mikrodoppler-Effekts zur präzisen Klassifizierung von Objekten. Hierbei vertrauen wir auf Produkte von Texas Instruments wie den AWR1243 und AWR2243, sowie auf uRad Radar-Sensoren wie den RaspberryPi uRAD und den Automotive uRAD.

Kalibrierung

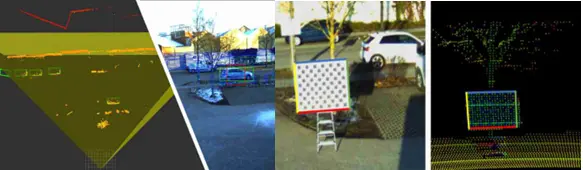

In einem Multisensorsystem misst jeder Sensor die äußere Umgebung in seinem eigenen Koordinatensystem. Um jedoch die Daten dieser Sensoren zu verarbeiten und zu verschmelzen, müssen die Daten von mehreren Koordinaten in einen Bezugskoordinatenrahmen transformiert werden. Dieser Referenzrahmen kann einer der Sensorrahmen, ein Bodenreferenzrahmen, ein Fahrzeugreferenzrahmen oder ein Weltreferenzrahmen sein. Der Prozess der Ermittlung der korrekten mathematischen Transformation wird als extrinsische Kalibrierung bezeichnet.

In ähnlicher Weise ist für jeden Sensor auch eine intrinsische Kalibrierung erforderlich. Ziel der intrinsischen Kalibrierung ist die Parametrisierung eines Projektionsmodells, welches Objektpunkte aus dem 3-dimensionalen Raum schließlich auf die entsprechende Position des Bildsensors projiziert. Damit enthalten die intrinsischen Parameter unter anderem entscheidende Informationen zur Optik des Sensors, wie dessen effektive Brennweite und den Grad der Linsenverzeichnung. Im Allgemeinen werden zur intrinsischen Kalibrierung eine Familie von Targets mit fest definierter Anordnung von sogenannten "Features" verwendet. Diese werden durch den Kalibrieralgorithmus im Bild detektiert und mit der Lage der Features im Raum in Verbindung gebracht.

Sowohl für die intrinsische als auch extrinsische Kalibrierung von Sensoren werden im Rahmen der Forschung neue Algorithmen entwickelt.

Ansprechpartner

Marcel Kettelgerdes, M. Sc.

Tel.: +49 841 9348-6451

Raum: S421

E-Mail: Marcel.Kettelgerdes@thi.de

Offene Stellen

Falls Sie Interesse an offenen Stellen für Studentische Arbeiten innerhalb der Forschungsgruppe haben, senden Sie bitte eine Mail mit Lebenslauf an assistenz-iimo-elger@thi.de.